![QANplatform AMA [Jan 25] with Johann Polecsak, Co-Founder and CTO](https://i.ytimg.com/vi/YstSmHAXYyU/hqdefault.jpg)

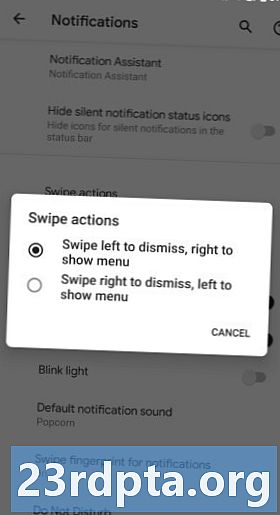

Qualcomm hat auf dem AI Day in San Francisco eine noch umfassendere Ankündigung gemacht. Der Riese der mobilen Chips spielt erneut für Server, nachdem er bereits 2018 seine Centriq-Produktreihe aufgegeben hat. Dieses Mal nutzt das Unternehmen seine Technologien im Bereich der KI, um die Tür zum Cloud-Computing zu öffnen. Der erste Chip, den wir nannten, war die Qualcomm Cloud AI 100-Plattform.

Bei der Cloud AI 100-Plattform handelt es sich nicht um ein Mobile-Chip-Repackage, sondern um ein grundlegendes 7-nm-Design für KI-Inferenzaufgaben und nicht für Schulungen. Das bedeutet, dass der Chip die Zahlen, die durch neuronale Netze laufen, zerquetscht, anstatt sie zu trainieren. Dies scheint Qualcomm in direkten Wettbewerb mit Nvidias Tesla T4-Serie und Google Edge TPU-Inferenzchips für Server und Cloud Computing zu bringen. Qualcomm hat genau wie seine Konkurrenten erkannt, dass die effizienteste KI-Verarbeitung nicht auf CPUs, GPUs und FGPAs ausgeführt wird, sondern einen dedizierten KI-Beschleuniger erfordert.

In Bezug auf die Leistung schätzt Qualcomm, dass die maximale AI-Leistung des Snapdragon 855 um mehr als das 50-fache gesteigert werden kann. Der Snapdragon 855 bietet eine Leistung von rund 7 TPS, was darauf hindeutet, dass der Cloud AI 100 im Bereich von 350 TPS liegt. Das wird dem T4 von Nvidia sicherlich den Garaus machen. Qualcomm geht davon aus, dass die Leistung pro Watt um das Zehnfache verbessert werden kann, verglichen mit den branchenweit fortschrittlichsten KI-Inferenzlösungen, die derzeit eingesetzt werden. Wenn Sie große Zahlen knacken, kann die Energieeffizienz Unternehmen enorme Summen an Stromrechnungen ersparen. Darüber hinaus möchte Qualcomm sein Know-how im Bereich Signalverarbeitung und 5G nutzen, damit seine Cloud-Plattform auch in zukünftigen Netzwerken mit sehr geringer Latenz am Rande funktioniert.

Wenn Sie gefragt werden, würde Qualcomm nicht kommentieren, ob die in der Cloud AI 100 verwendete Architektur proprietär oder von einer anderen Stelle lizenziert war. Ich frage mich, ob dies das erste Erscheinungsbild der Trillium AI-Architektur von Arm ist, die auch speziell für Inferenz-Workloads mit geringem Stromverbrauch entwickelt wurde. Aber genug Spekulationen, sagt Qualcomm, dass es in Zukunft mehr Informationen über seine AI-Architektur teilen wird.

Um Entwickler zu unterstützen, arbeitet Qualcomms Cloud AI 100 mit den meisten, wenn nicht allen branchenführenden Software-Stacks zusammen. Es werden Caffe-, Keras-, mxnet-, TensorFlow-, PaddlePaddle- und Cognitive Toolkit-Frameworks sowie Glow-, OnnX- und XLA-Laufzeiten unterstützt.

Die Qualcomm Cloud AI 100 wird voraussichtlich ab dem Jahr 2010 an Kunden ausgeliefert